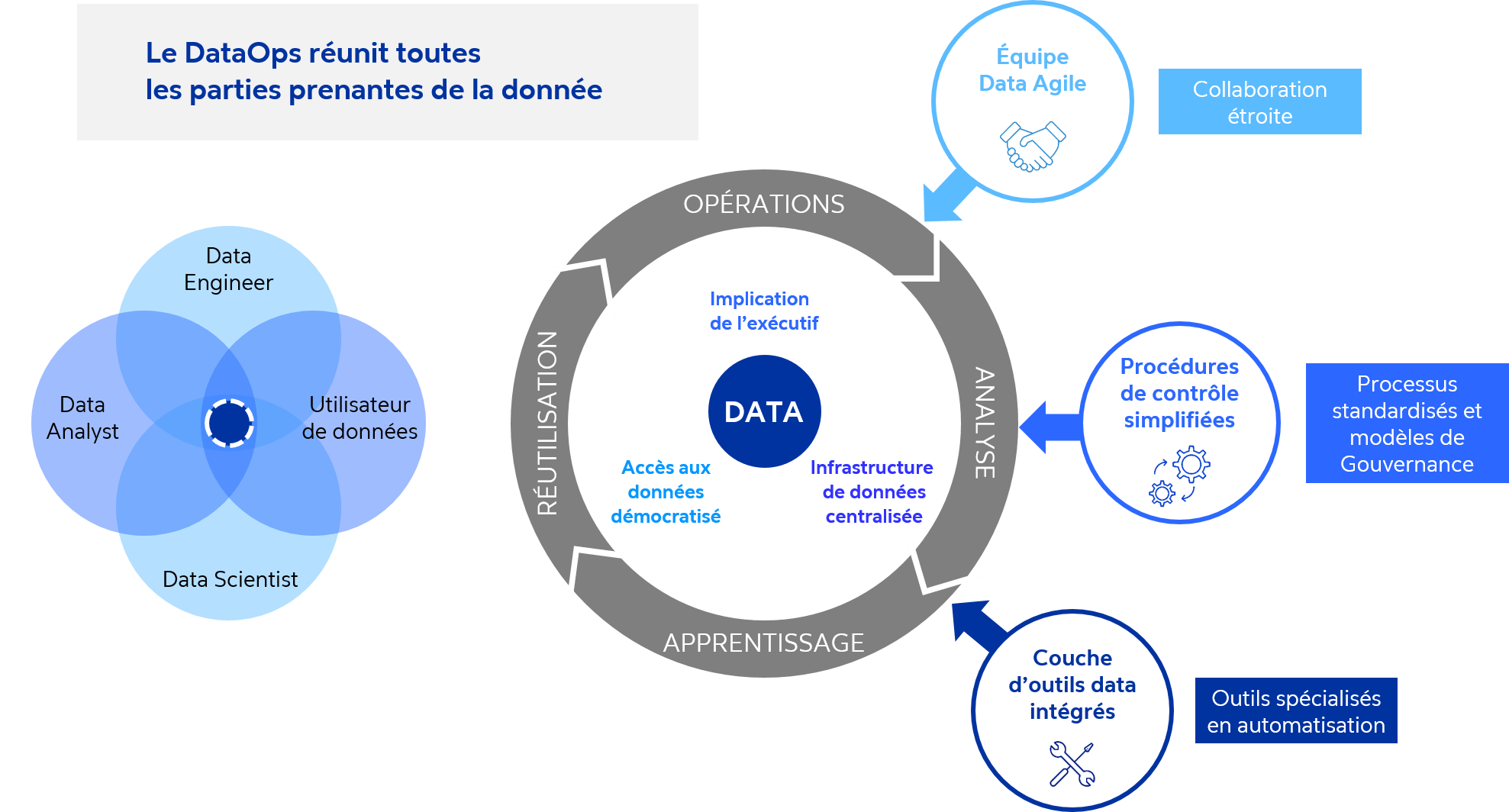

Le DataOps fournit des pipelines de données reproductibles et réutilisables qui permettent la production en continu des données et des modèles d’IA dont l’entreprise a besoin – pour ensuite analyser et générer les informations nécessaires à la prise de décision business.

En effet, le DataOps permet de :

- Réduire le temps et les efforts de collecte, de stockage et d'intégration des données – tout en indiquant quelles données doivent être utilisées, comment elles doivent être appliquées et par qui. En promouvant la collaboration étroite entre les data scientists et les utilisateurs métiers, le DataOps permet de garantir que les projets analytiques se concentrent exclusivement sur la collecte des données destinées à répondre aux besoins business les plus urgents. Son utilisation de sprints agiles aide les data scientists à développer rapidement de nouveaux ensembles de données et modèles analytiques plutôt que d'attendre la fin d'un long processus de développement incrémental pour découvrir qu'ils se concentraient sur le mauvais problème. Par exemple, si un fabricant d'électronique grand public souhaite estimer les ventes d’un appareil connecté et en prévoir la demande pour les six prochains mois, les résultats peuvent être obtenus en quelques semaines (plutôt qu'en quelques mois) avec les processus DataOps.

- Condenser le temps nécessaire pour recueillir et analyser les données. Le DataOps fournit des pipelines intelligents de données qui garantissent la convergence en continu de celles-ci depuis les systèmes internes et externes de l’entreprise vers les plateformes analytiques. Des processus tels que le nettoyage des données, la suppression des valeurs aberrantes et le codage des variables se trouvent ainsi automatisés. Le DataOps permet en continu l’intégration, le déploiement et le test des plateformes de stockage et d’analyse de données, y compris celles prévues pour l’IA – réduisant ainsi le délai de livraison à une journée.

- Fournir un accès facilité et universel à toutes les données. L'accès en libre-service et les outils intuitifs de visualisation permettent à toutes les parties prenantes des données d'accéder plus facilement aux données dont elles ont besoin, partout et à tout moment. Les portails DataOps automatisent la création de nouveaux projets en utilisant les meilleures pratiques et standards du marché à chaque étape - de la création et du réglage de l'infrastructure cloud au test automatisé, au déploiement de code et à l'intégration. Auparavant, pour chaque projet d’analytics, les data analysts, les data scientists et les utilisateurs métiers devaient travailler avec de nombreuses parties prenantes pour enrichir les données. Avec pour conséquence : des processus lourds et chronophages d'approbation et d’explications qui retardaient d’autant la phase de création du modèle. Avec le DataOps, ils peuvent désormais travailler plus rapidement au sein des mêmes processus, ce qui permet à l'entreprise d’obtenir immédiatement des résultats des projets d'analytics.

- Réduire le temps et les coûts permettant d’assurer la qualité des données tout au long du pipeline. Les pipelines de production de données fournissent la matière première pour l'intelligence artificielle et l'apprentissage automatique. Les tests continus sur les modèles analytiques, sur les actifs réutilisables et sur les algorithmes d'apprentissage automatique réduisent le time-to-value des analyses basées sur l'IA. Les paradigmes intelligents appliqués à la qualité des données permettent d’identifier et signaler des comportements dans les ensembles de données qui peuvent aider les développeurs de modèles d'IA à comprendre la relation métier entre les attributs et à affiner leurs modèles.

- Diminuer les efforts et les coûts requis pour créer des services et des actifs de données. Dans le DataOps, la sortie de chaque étape du pipeline d'analyse de données constitue l'entrée de l'étape suivante. Cela crée des composants plus petits, tels que des scripts, du code source, des algorithmes, des fichiers de configuration HTML, des fichiers de paramètres et des modèles analytiques qui peuvent être utilisés par d'autres membres de l'équipe. Cela réduit les coûts et le temps de développement, ce qui permet aux équipes data de se concentrer sur la maximisation de la valeur des données et la réponse au besoin métier.

Le DataOps étend l'efficacité fournie par le DevOps

Il y a toujours eu des approximations et des débats enflammés pour définir le DevOps et le DataOps comme des méthodologies. Cependant, ces termes ne sont pas aussi similaires qu'ils le paraissent et l’impact réellement positif survient lorsque les deux méthodologies sont appliquées ensemble. Une approche combinée donne une solution plus réussie, fiable, robuste, évolutive et reproductible.

Comment le DataOps peut-il être utilisé aujourd'hui ?

Au cours de la pandémie de la Covid-19, des data scientists basés aux Etats-Unis ont pu tirer parti des capacités du DataOps et rapidement créer des modèles pour prédire les nouveaux cas par états, villes et comtés en collectant les données du CDC (Center for Disease Control, USA) et les données des réseaux sociaux comme Facebook, Twitter et LinkedIn. Ils ont pu ensuite répondre à des questions comme : quelles actions sont nécessaires ? Comment et où protéger les personnes ? Comment adapter le business en réponse à la progression du virus ?

Le chemin vers le DataOps est une évolution permanente qui nécessite de repenser la technologie, les personnes et les processus. Il implique de traiter la donnée comme un produit qui peut être automatisé et rationalisé, et de lui appliquer une philosophie et des process de product development. Avec pour résultat : la génération accélérée de valeur business pour tous vos investissements en data analytics.