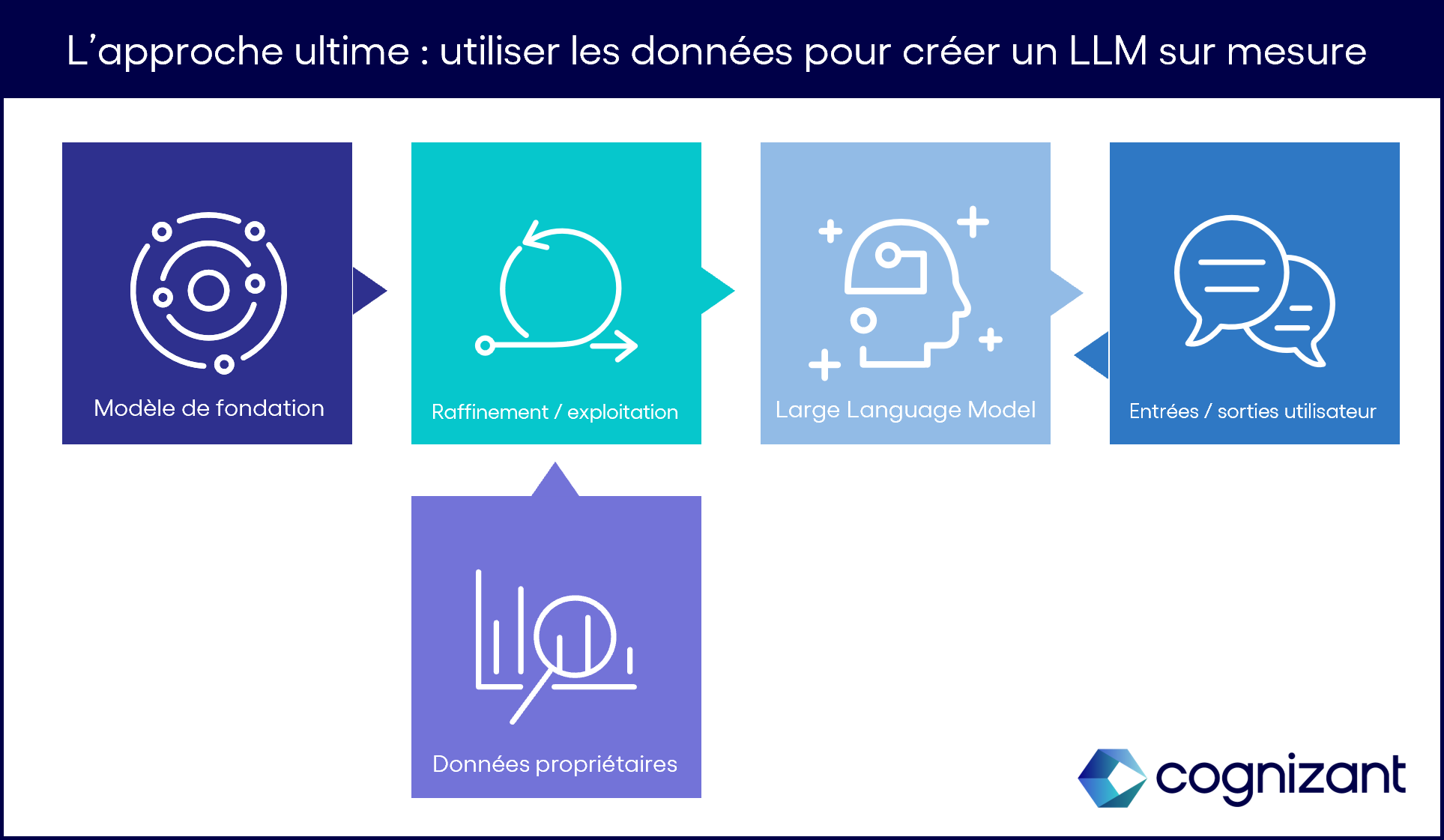

Cependant, même dans ce cas, la qualité du résultat obtenu et la qualité du processus global seront contraintes par la qualité et l’accessibilité des données avec lesquelles le modèle devra travailler.

Cinq critères essentiels pour une architecture prête à l’emploi

On le voit : quelle que soit l’approche choisie, les chances de succès de la stratégie de GenAI seront étroitement corrélées à la performance de l’architecture de données existante. Parmi les critères à valider, cinq apparaissent particulièrement critiques :

- L’indexation des données et la création de métadonnées

- La fiabilité des données

- La sécurité des données

- L’élasticité des systèmes

- La capacité de refaire travailler les jeux de données

1. L’indexation des données et la création de métadonnées

Même aux yeux d’un réseau de neurones performant et précis comme un LLM moderne, la donnée en elle-même ne veut rien dire si elle n’est pas proprement identifiée et indexée. La première étape dans la préparation de la donnée consiste donc à localiser celle-ci dans un répertoire centralisé, où des métadonnées complètes décriront sa source, sa structure, son contenu et, idéalement, sa signification. Si, comme on l’espère, les LLMs évoluent jusqu’à devenir des assistants pour les utilisateurs humains, ils devront non seulement accéder à toutes les données pertinentes pour une requête adressée en langage naturel, mais aussi à toutes les informations qui permettent de situer le contexte et la signification de la donnée. Sans cet effort de précision dans la gestion des métadonnées, les LLM seront privés de toute capacité opérationnelle.

2. La fiabilité des données

Autre critère essentiel : la fiabilité des données – d’autant plus si l’entraînement des modèles d’IA générative reposent sur celles-ci, comme c’est le cas avec l’approche de LLM customisé. C’est pourquoi, avant de se lancer dans une stratégie de GenAI, les entreprises devraient déjà faire le point sur le niveau de confiance que les équipes attribuent à leurs systèmes d’analytique, de reporting et de Business Intelligence (BI). Si le sentiment qui prédomine est plutôt le doute ou la méfiance, les dirigeants seront plus avisés d’engager des investissements pour résoudre ces problèmes que de mobiliser des ressources pour entraîner les modèles LLMs sur des données de qualité insuffisante.

3. La sécurité des données

L’enjeu de sécurité est un pilier fondamental de toute stratégie de données moderne. Mais, avec l’IA générative, les risques de voir son système de défense rapidement mis à nu, et ses points faibles exposés au grand jour, seront amplifiés et accélérés. En cause : l’absence de prédictibilité et de déterminisme dans le comportement d’un LLM qui rend difficilement prévisibles les dérives qu’il pourrait occasionner s’il venait à tomber dans des mains malveillantes – à commencer par la divulgation de données propriétaires, telles que des données confidentielles sur l’entreprise ou sur ses clients.

Cette menace est peut-être plus marquée lorsque les entreprises ont recours à l’approche sur étagère (celle enrichie par le RAG) car le modèle interagit plus fréquemment avec les données propriétaires, multipliant ainsi les occurrences d’ouverture du système et donc les risques de brèche pour des esprits mal intentionnés. Cependant, même si nous ne pouvons encore envisager l’étendue des menaces que véhiculent ces détournements de l’IA générative, il y a fort à parier que les entreprises les plus résistantes à ces attaques seront précisément celles qui, dès aujourd’hui, présentent les stratégies les plus efficaces de protection de leurs données sensibles.

4. L’élasticité des systèmes

Pour maximiser les gains engendrés par l’IA générative, les entreprises devront non seulement mettre à niveau leurs pipelines de données pour fournir aux LLMs la matière première à traiter, mais également créer un flux et une architecture de sortie pour recueillir et stocker le déluge de nouvelles données générées par le modèle. La construction de cette architecture de données doit intervenir en amont de tout projet de traitement, et elle doit se montrer suffisamment adaptable pour gérer un flux d'informations à la croissance linéaire, voire exponentielle, année après année.

Dans cette optique, il peut être intéressant de commencer à se pencher sur une modernisation des systèmes de stockage : là où les entrepôts de données ou les systèmes SGBDR pourraient s’avérer coûteux et limitants dans la quantité de données stockées et traitées, des architectures modernes de type « data lakehouse » et des systèmes de stockage d’objets dans des clouds évolutifs tels que S3 ou GCS pourraient faire la différence.

5. La capacité de refaire travailler les jeux de données

Paradoxalement, plus les modèles avanceront vers l’avenir, plus le besoin de revisiter le passé se fera pressant. Ainsi, dans les phases d’entraînement, de raffinement et de test d’un LLM, la capacité de restaurer et de refaire travailler des versions antérieures d’un jeu de données sera de plus en plus critique, y compris pour les entreprises qui envisagent un LLM sur étagère (pré-entraîné, pré-réglé et pré-testé). Cette capacité de réutilisation et de « rejouabilité » des systèmes de données existants est d’ailleurs un baromètre intéressant pour mesurer le degré de préparation de la donnée en vue d’une approche d’IA générative.

Cette dernière remarque vaut d’ailleurs pour tous les critères évoqués dans l’article : gestion des métadonnées, sécurité, fiabilité, adaptabilité… Au fur et à mesure que l’IA générative apposera sa signature sur des transformations structurantes, il deviendra capital pour les entreprises de prendre en compte tous ces critères et de construire une fondation solide de données si elles ne veulent pas se trouver distancées. Tout projet précipité d’investissement dans un LLM qui s’appuierait sur des architectures encore trop limitées ou des jeux de données non vérifiés, risquerait au contraire de faire perdre un temps précieux à l’entreprise qui le porte.

À l’heure où les avantages compétitifs se font et se défont au rythme des promesses portées par les IA génératives, il est capital de conserver une approche structurée et raisonnée en matière de données car celles-ci restent le maillon essentiel des transformations à venir.